RAG 파이프라인 구축: 벡터DB 선택과 프롬프트 전략까지 (실전 가이드)

RAG 파이프라인 구축: 벡터DB 선택과 프롬프트 전략까지 (실전 가이드)

RAG 파이프라인을 올바르게 설계하면 사내 문서·매뉴얼·로그 같은 비정형 데이터를 즉시 검색해 답하는 실무형 AI를 만들 수 있습니다. 이 글은 RAG 시스템 구축의 핵심인 데이터 파이프라인, 벡터DB 선택, 검색·리랭킹·생성 최적화, 운영과 보안까지 실전 관점으로 정리했습니다.

RAG 시스템 구축을 처음부터 끝까지 따라 하는 실전 가이드입니다. 수집→전처리→분할→임베딩→인덱싱→검색→리랭킹→프롬프트→생성→평가의 전 과정을 다루고, FAISS·Milvus·OpenSearch·Pinecone 등 벡터DB 비교와 비용·성능 튜닝, 모니터링·보안 팁, 파이썬 예제 코드까지 제공합니다.

목차

1. RAG 시스템이 왜 필요한가

2. 데이터 파이프라인: 분할·임베딩·인덱싱 설계

3. 벡터DB 비교와 선택 기준

4. 검색·리랭킹·프롬프트 최적화 전략

5. 운영·보안·비용과 실전 코드

1. RAG 시스템이 왜 필요한가

핵심 요약: 사내 지식을 최신 상태로 연결해 환각을 줄이고, 유지비를 예측 가능하게 만든다.

일반 LLM은 훈련 시점 이후의 지식을 모릅니다. RAG 시스템 구축은 외부 지식 소스를 실시간으로 조회해 답변의 근거를 함께 제시하기 때문에, 환각(Hallucination)을 크게 줄입니다. 또한 모델을 재학습하지 않고도 문서만 교체하면 지식이 업데이트되어 운영 부담이 낮습니다.

RAG 시스템 구축의 장점은 다음과 같습니다. 첫째, 근거 기반 응답으로 신뢰도를 높입니다. 둘째, 도메인 적합성이 뛰어나 개발 문서, 고객 FAQ, 정책 문의 등에서 즉시 효과가 납니다. 셋째, 비용 통제가 쉽습니다. 인덱싱은 오프라인으로, 검색·생성은 온라인으로 분리되어 규모를 유연하게 조절할 수 있습니다.

2. 데이터 파이프라인: 분할·임베딩·인덱싱 설계

핵심 요약: 텍스트 분할과 메타데이터가 검색 품질을 80% 좌우한다.

2.1 수집·정제

PDF, 웹페이지, 위키, 티켓 시스템 등 출처가 다양한 만큼, 중복 제거와 스냅샷 버저닝이 중요합니다. 문서 ID, 버전, 수집 시각을 메타데이터로 저장해 지식의 시점을 추적하세요.

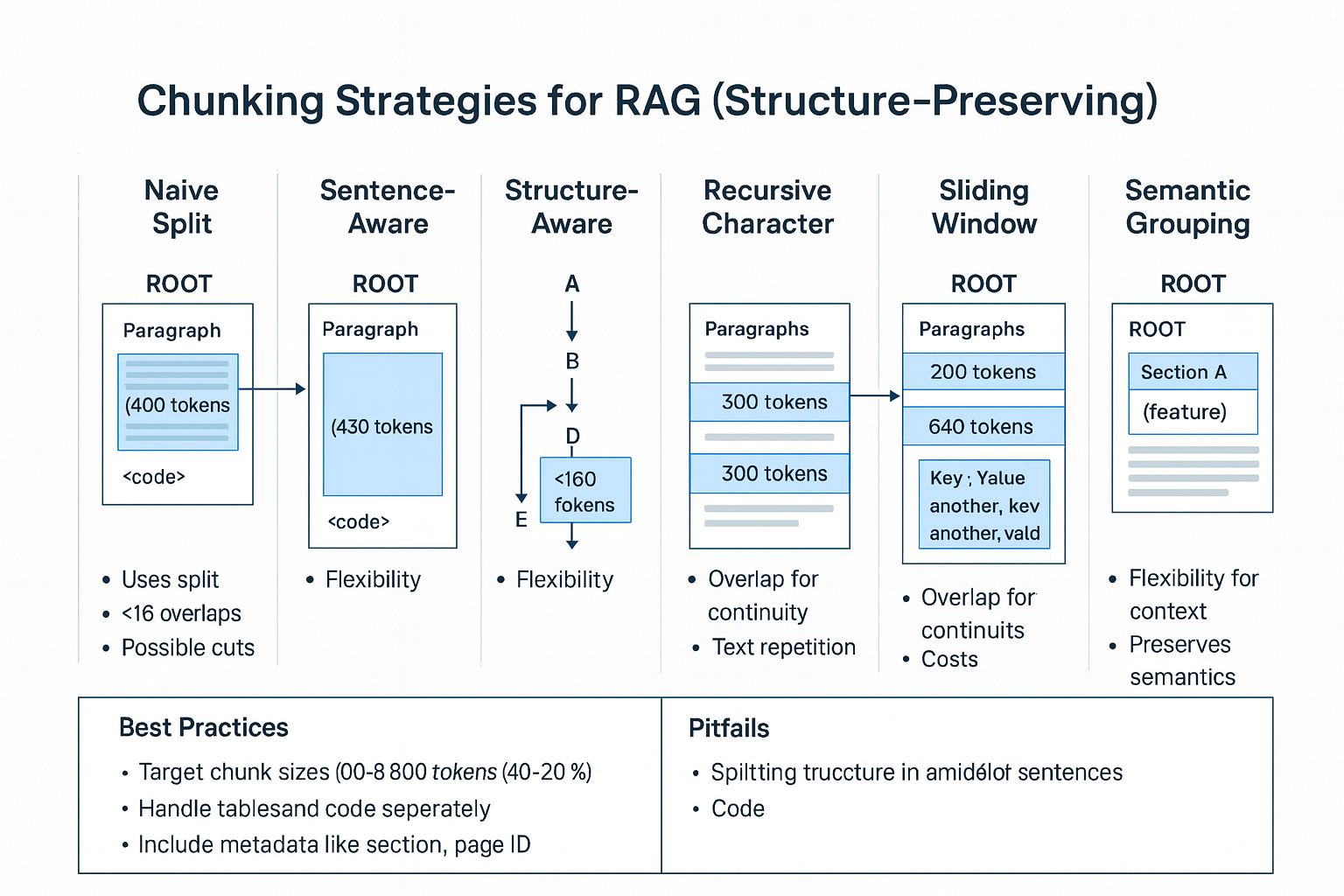

2.2 분할(Chunking) 전략

RAG 파이프라인에서 가장 흔한 실수는 너무 큰 청크입니다. 500~1,000 토큰 범위를 기본값으로 하되, 문단/제목/코드블록 경계를 보존하는 구조 인지 분할을 권장합니다. 슬라이딩 윈도(window) 10~20% 오버랩을 두면 문맥 단절을 줄일 수 있습니다. 도메인에 따라 표·코드는 별도 청크로 분리하세요.

2.3 임베딩 모델 선택

범용 서비스는 대체로 대형 상용 임베딩(예: 최신 상용 임베딩 모델)이나 공개 모델(bge, e5, jina 계열)을 사용합니다. 다국어·한글 정확도가 중요하면 한글 튜닝 모델을 테스트하세요. 정확도 vs 비용의 균형을 위해 차원 수(dimension)와 정규화 여부를 확인하고, 동일 모델로 인덱스와 쿼리를 맞추는 것이 RAG 시스템 구축의 기본입니다.

2.4 인덱싱과 메타데이터

메타데이터에는 출처(URL/파일명), 페이지 범위, 섹션 헤더, 라벨(팀/시스템), 기밀 등급을 넣습니다. 이 메타데이터는 필터링 검색(예: 제품=App, 버전>=2.0)과 근거 렌더링에 필수입니다. 인덱스는 HNSW/IVF-PQ 등 근사 최근접(ANN) 방식을 주로 사용하며, 리콜과 지연의 트레이드오프를 벤치마크하세요.

3. 벡터DB 비교와 선택 기준

핵심 요약: 운영 제약(배포 방식·SLA·규모)과 기능(필터·하이브리드·스케일)을 우선 본다.

3.1 로컬/내장형

- FAISS: 단일 노드·로컬 인덱싱에 강함. 파이프라인 초기 실험과 오프라인 평가에 적합. 운영 기능(ACL·샤딩)은 직접 구현이 필요합니다.

3.2 오픈소스/클러스터형

- Milvus/Vald: 대규모 스케일아웃과 다양한 인덱스(HNSW, IVF) 지원. 쿠버네티스 배포와 모니터링 도구가 성숙했습니다.

- OpenSearch(k-NN/Vector): 토큰 검색(BM25)과의 하이브리드 검색을 기본 제공해 긴 쿼리·키워드가 많은 환경에서 강력합니다.

3.3 매니지드 서비스

- Pinecone/Weaviate Cloud 등: 운영을 최소화하고 지연·SLA를 보장. 서버리스 요금제로 시작 장벽이 낮고, 필터·스코어링이 잘 정돈되어 있습니다.

3.4 선택 체크리스트

- 데이터 민감도/규제: 온프레미스가 필요한가?

- 규모와 지연: QPS, 벡터 수, SLA 목표.

- 하이브리드 검색: BM25+벡터가 필요한가?

- 필터/메타 쿼리: 구조화된 필터가 중요한가?

- 운영 편의성: 백업·스냅샷·모니터링·자동 스케일.

- 비용 모델: 스토리지/조회/인덱싱 비용과 데이터 송신 요금.

RAG 시스템 구축에서는 종종 하이브리드 검색 + 리랭킹이 순수 벡터보다 안정적입니다. 쿼리 의도에 따라 가중치를 동적으로 조정하는 쿼리 라우터를 두면 품질이 높아집니다.

4. 검색·리랭킹·프롬프트 최적화 전략

핵심 요약: “가져오기 정확도”와 “생성 통제” 두 축을 동시에 튜닝한다.

4.1 검색 단계 튜닝

- 하이브리드 검색: BM25와 벡터 점수를 혼합하거나, 키워드 부스팅(term boosting)으로 최신성/정확도를 조절합니다.

- 동의어·스펠링 교정: 사용자 오타·약어를 확장합니다. 도메인 용어 사전을 관리하면 RAG 파이프라인 전반의 리콜이 상승합니다.

- 쿼리 확장(Query Expansion): 사용자 질문을 의도·맥락 프롬프트로 확장해 더 나은 후보를 검색합니다.

4.2 리랭킹(Reranking)

Cross-Encoder 계열 리랭커는 문서-쿼리 매칭을 정밀하게 평가합니다. 상위 k=50을 검색 후 k'=5로 리랭킹해 정밀도(Precision)를 높이세요. 계산량이 부담되면 경량 모델을 섞어 2단계 리랭킹(빠른 점수 → 정밀 점수)으로 타협합니다.

4.3 프롬프트 구성

- 근거 고정형 프롬프트: “다음 근거만 사용하여 답하라. 인용에 출처를 표기하라.”와 같이 사용 범위를 제한합니다.

- 포맷 강제: JSON Schema/함수 호출을 사용해 구조화 응답을 강제하면 후처리가 쉬워집니다.

- 거부 규칙: 근거 부족 시 정중히 거절하도록 Fallback 프롬프트를 넣어 환각을 더 줄입니다.

4.4 평가(Eval)

RAG 시스템 구축의 성능 평가는 Retrieval Precision/Recall, Answer Faithfulness, Context Utilization 등을 지표로 삼습니다. 샘플 100~300개에 대해 자동 평가+소규모 휴먼 검증을 병행하세요.

5. 운영·보안·비용과 실전 코드

핵심 요약: 데이터 계보 추적, PII 마스킹, 캐시·배치 혼합으로 비용을 줄인다.

5.1 운영·모니터링

- 지식 스냅샷 버전을 응답에 표기하고, 클릭률/만족도/수정율을 대시보드로 추적합니다.

- 성능 알림: 검색 공백률(0-hit), 리랭킹 지연, 토큰 사용량이 임계치를 넘으면 슬랙 알림.

5.2 보안·거버넌스

- 업로드 단계에서 PII/비밀 키 탐지를 자동화하고, 민감 문서는 인가된 사용자만 검색되도록 Row-Level Security를 적용합니다.

- 프롬프트 주입 방어: 시스템 프롬프트에 규칙을 명시하고, 도메인 화이트리스트 외 URL은 무시하도록 파서 계층을 둡니다.

5.3 비용 최적화

- 자주 쓰는 문서는 결과 캐시(질문→답)와 임베딩 캐시(문서→벡터)로 중복 비용을 줄입니다.

- 임베딩 배치는 야간에 실행하고, 생성 모델은 요청량에 따라 서버리스/온디맨드로 선택합니다.

5.4 파이썬 최소 예제

다음은 간단한 RAG 파이프라인 데모입니다(벡터 저장은 FAISS, 검색 후 상위 4개로 답변).

# pip install langchain faiss-cpu openai tiktoken

from langchain.embeddings import OpenAIEmbeddings

from langchain.vectorstores import FAISS

from langchain.text_splitter import RecursiveCharacterTextSplitter

from langchain.chat_models import ChatOpenAI

from langchain.chains import RetrievalQA

# 1) 문서 로딩(예시)

docs = [

("guide.md", "RAG is a pattern that augments LLMs with external knowledge..."),

("policy.md", "Access to production requires MFA and role-based access...")

]

# 2) 분할

splitter = RecursiveCharacterTextSplitter(chunk_size=800, chunk_overlap=120)

texts = []

metadatas = []

for name, content in docs:

for chunk in splitter.split_text(content):

texts.append(chunk)

metadatas.append({"source": name})

# 3) 임베딩 & 인덱싱

emb = OpenAIEmbeddings() # 동일 모델로 쿼리/인덱스

vs = FAISS.from_texts(texts, emb, metadatas=metadatas)

# 4) 검색 + 생성 체인

llm = ChatOpenAI(temperature=0)

qa = RetrievalQA.from_chain_type(llm=llm, retriever=vs.as_retriever(search_kwargs={"k":4}))

print(qa.run("What is RAG and why is it useful for enterprise docs?"))

코드의 핵심은 같은 임베딩 모델을 사용하고, 청크 크기/오버랩을 합리적으로 설정하는 것입니다. 운영 단계에서는 리랭킹, 필터링, 하이브리드 검색을 추가하세요.

결론

핵심 요약: RAG 시스템 구축의 성패는 데이터 파이프라인과 검색 품질에 달려 있다.

대부분의 문제는 모델이 아니라 데이터 청크·메타데이터·검색 전략에서 시작합니다. 작게 시작해 실험 가능한 벤치마크 세트를 만들고, 하이브리드 검색과 리랭킹을 더한 뒤 프롬프트를 구조화하세요. 이렇게 RAG 파이프라인을 표준화하면 팀은 빠르게 기능을 추가하고, 변화하는 문서를 안정적으로 반영할 수 있습니다.